馬斯克公布 X 推薦演算法 的革命性,以及沒說的那些事

2026 Jan 22 未分類

馬斯克公布 X 推薦演算法 的革命性,以及沒說的那些事

2026 年初,馬斯克兌現承諾,將 X(前 Twitter)的推薦演算法再次開源,還很謙虛的說這可能還是笨拙的演算法,會每四星期持續更新。這一舉動引發科技圈廣泛討論,被視為社群媒體透明化的重要一步。

根據 GitHub ,這次開源不僅涵蓋了核心程式碼,還包括詳細的架構說明,讓開發者和研究者能夠直接檢視和測試系統。

社群形容這是「純 ML 肌肉取代手工特徵」的轉變,甚至有人強調這是「端到端學習 transformer」的里程碑,預示 X 朝向更少人工干預的推薦系統演進。

▋開源了什麼推薦演算法?

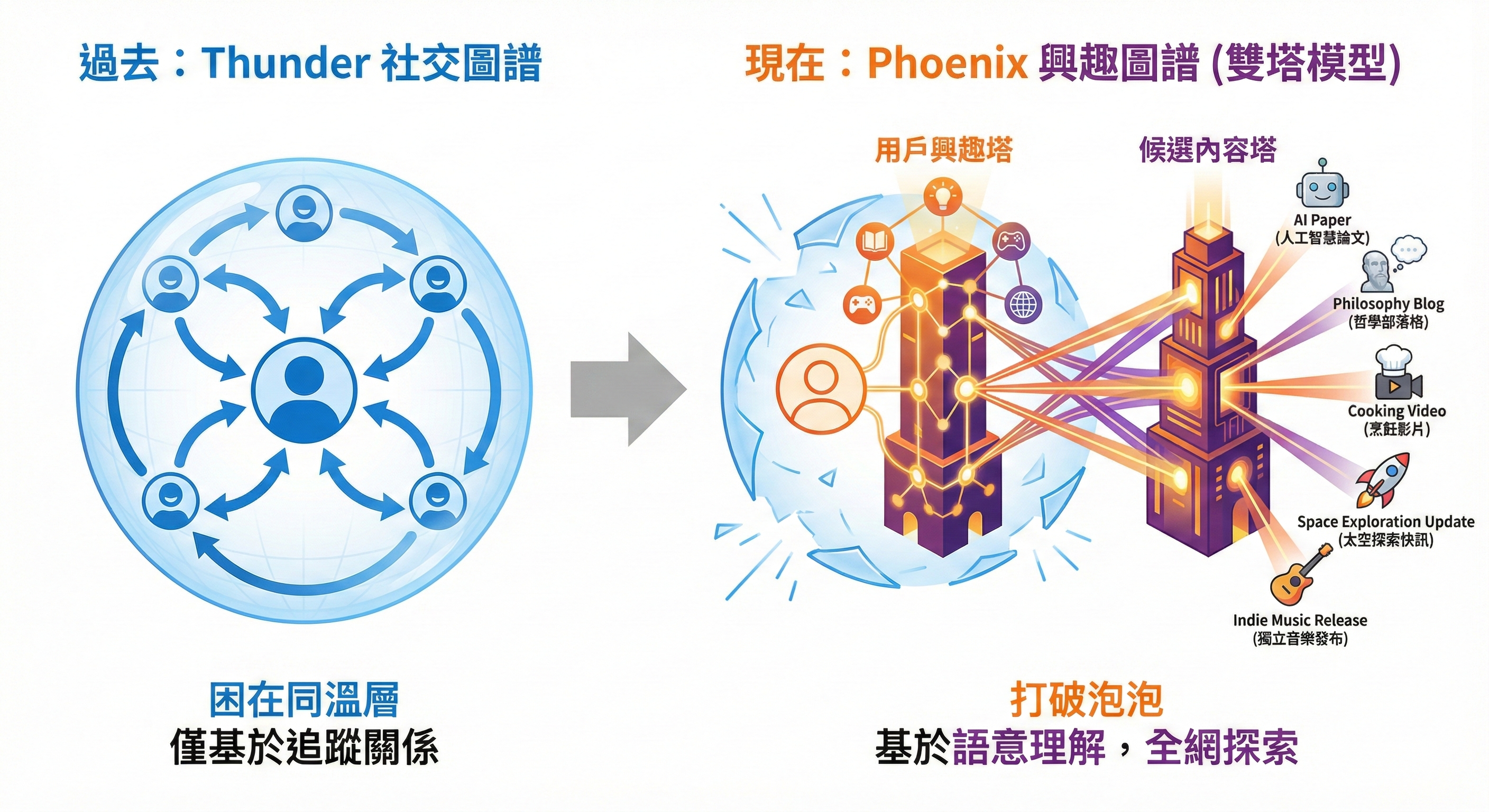

過去的 Thunder 模組,主要依賴社交圖譜,強調追蹤關係和已知圈子的內容。這是傳統推薦的遺產,計算延遲極低(sub-millisecond 級),但容易導致用戶困在「社交泡泡」中,缺乏新鮮發現。在 2023 年的舊版開源中,Thunder 仍是核心,但如今它被定位為輔助角色。

在這次更新中,演算法革命性的引入 Phoenix 模組,這是一個基於 Grok 驅動的興趣圖譜。以雙塔模型的架構,平衡用戶熟悉內容與全網探索。所謂的雙塔是分別處理用戶興趣向量(用戶塔)和內容向量(候選塔),透過向量相似度計算(dot product)來推薦內容。

這讓「猜你喜歡」更進一步,系統不只看表面關鍵字,還能捕捉語意層面的相關性,例如將一篇關於 AI 倫理的貼文推薦給對哲學感興趣的用戶,即使他們未追蹤作者。

系統設計讓 Thunder 與 Phoenix 合作:Thunder 處理 in-network 內容(追蹤帳號)的熟悉內容(基於使用者互動歷史),Phoenix 處理 out-of-network 全網內容(基於語意相關性)。

整個流程由 Home Mixer 協調,包括候選來源(sourcing)、資料填充(hydration)、過濾(filtering)、重排名(heavy ranking)、混合(mixing)和安全檢查(safety/heuristic polishing)。

這種模組化管線確保效率,避免了跨候選注意(no cross-candidate attention),讓每個候選獨立評分,便於快取和並行計算。

不僅如此,還有助於避免傳統社交泡泡效應,讓用戶接觸更多樣化的視角。

例如,系統會從全網數億貼文中,使用近似最近鄰搜尋(ANN)檢索與用戶向量最相似的內容,維度可能高達數百或數千,確保推薦不僅熟悉,還具探索性。

社群如 @thebayeram 分享的策略指南中,強調這讓創作者需專注「停止滾動」(stop the scroll),透過高品質媒體提升停留時間(dwell time)。

對創作者而言,這項轉變意味著重點從「你是誰」(如粉絲數或身份)轉向「你寫什麼」(內容的語意深度和相關性),讓優質內容更容易跨圈層傳播。

系統預測 19 種用戶反應(而非原先的 15 種),從按讚、回覆、轉推,到屏蔽、報告、停留時間、影片觀看等,深度回覆(多來多往)被認為是更高品質的文章特質。

最終分數是加權和(final_score = Σ(weight_i × P(action_i))),其中回覆和停留時間權重最高,負面信號如屏蔽則重罰。

此外,作者多樣性懲罰(Author Diversity Scorer)會降低同一作者連續貼文的權重,避免洗版。

X 員工宣稱,新的演算法讓使用者停留時間增加 20-30%(社群討論中如 @TestingCatalog 提到 20%,但內部數據可能更高),這得益於 Grok transformer 的精準預測,讓推薦更吸引人。

▋怎麼可能把大模型用在即時推薦上?

大模型很貴的,我一天問幾次問題就問到額度爆滿。怎麼可能用在即時推薦上?

這是許多分析師的疑問,尤其考慮到 X 每日處理上億貼文,延遲需控制在秒級內。

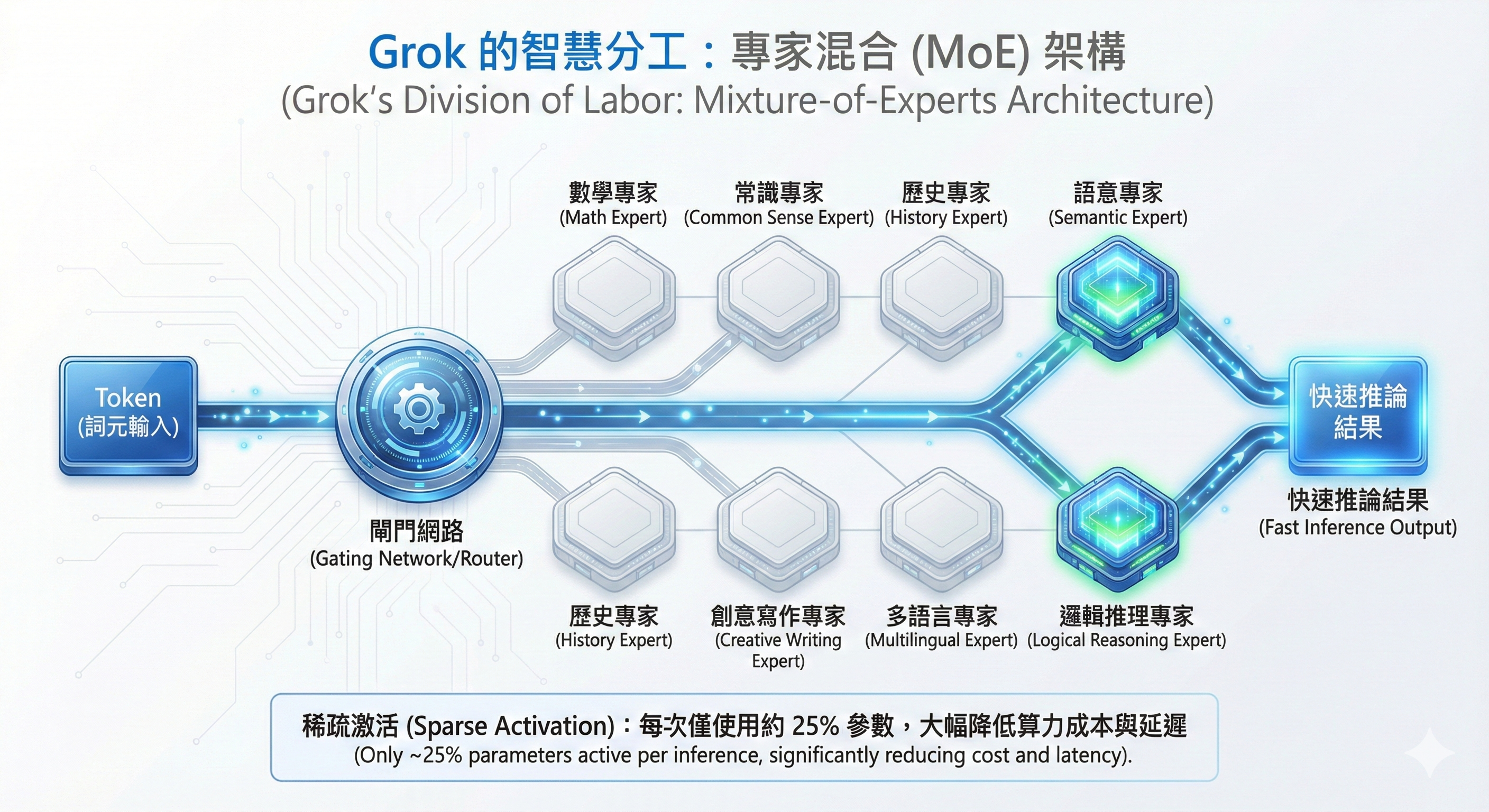

推測可能是因為 Phoenix 的核心依賴 Grok 模型進行特徵提取,而 Grok-1 採用 Mixture-of-Experts(MoE,專家混合)架構,每次只需要部分算力。這讓大模型從「全能巨人」轉為「智慧分工」系統。

這是一種高效的模型設計方式:總參數達 314 億(314 billion),但並非每次處理都激活全部參數。

MoE 將模型拆分成多個「專家」(experts,通常為 8 個獨立的子網路),每個專家專精於不同類型的資料或任務,例如一個專家處理文字語意,另一個專注圖像嵌入。

當輸入一個 token(詞元)時,一個「閘門網路」(gating network 或 router)會根據輸入特徵動態決定激活哪幾個專家(Grok-1 中為 2 個專家),僅激活約 25% 的參數(有效活躍參數約 78.5 億)。這叫做稀疏激活(sparse activation)。

這種機制讓模型在維持高容量(大量知識儲存)的同時,大幅降低計算成本和延遲,適合大規模即時應用。

在推薦場景中,這意味著 Grok 可以高效生成嵌入向量,而非每次完整推論,有人說,這與 Phoenix 的命名(鳳凰重生)呼應,象徵從舊架構中重生。

進一步來說,MoE 的優勢在於稀疏性:傳統模型如 GPT 系列需激活所有參數,導致高 GPU 消耗以及浪費;MoE 則透過路由器實現條件計算(conditional computation),讓計算複雜度將低,其中 k 是激活專家數。

如果想要的話,數據科學家可透過 GitHub 的 JAX 訓練代碼模擬,驗證 MoE 如何在 2 萬 GPU 規模下維持低延遲。

▋沒說的事:第一件,權重

表面上看,這是一場透明度的勝利:官方宣稱演算法現在基於強大的 Grok 模型,移除了所有人工特徵工程,實現了「零人工干預」的數學純粹性。

然而,當我們剝開行銷術語的外衣,深入架構時,會發現這場所謂的透明化革命,其實隱藏著三個技術圈心照不宣的秘密。

秘密一:公開了「大腦結構」,卻沒給你「記憶」

首先,開源程式碼(Code)並不等於模型(Model)。

X 公布的只是神經網絡的架構圖(Architecture),也就是工廠的流水線設計;但他們並沒有,也不可能公布「權重參數(Weights)」。權重是模型經過數兆次訓練後學到的「價值觀」,儲存於數十 GB 的檔案中,涵蓋 Grok transformer 的每一層參數。沒有權重,我們只知道模型「會思考」,卻不知道它「傾向於什麼」。這就像一位法官公開了他的法袍和法槌(架構),卻隱藏了他腦中對善惡的判斷標準(權重)。

因此,所謂的審計,在沒有權重的情況下,只能停留在理論層面。

這讓 Weighted Scorer 的最終公式(Σ weight_i × P(action_i))無法驗證,因為權重決定了政策偏好,例如是否偏好爭議內容。

數據科學家若想複製,需從頭訓練,成本高昂,這也是為何有人說這是「嘗試取代傳統特徵工程,但權重仍是黑箱」。

▋沒說的第2件事:屏蔽規則

官方宣稱新系統移除了手動特徵工程,完全依賴 AI 自主學習。這聽起來像是「數學統治一切」的烏托邦,但實際上,程式碼中依然充斥著大量「硬規則(Hard-coded Rules)」。

在 AI 算出分數後,判定文章順序前,必須先經過一層又一層的人類過濾器:封鎖名單、NSFW 檢測、仇恨言論過濾、RepostDeduplicationFilter(重複轉推過濾)和 AgeFilter(新鮮度過濾)。

這些並不是 AI 自己「悟」出來的道理,而是人類判斷後寫死的 if-else 邏輯,或基於關鍵字和模式匹配的規則。所謂的「零人工」,僅指 AI 在「挑選什麼是你喜歡的」變聰明了,但在「過濾什麼是平台不允許的」這件事上,人類的手從未離開。

事實上,負面信號模型特別強烈,直接預測並重罰屏蔽/報告,讓系統對拒絕敏感。

社群討論指出 VF Filter(暴力/過濾檢查)是後排名階段的安全網,確保合規內容才推送。

這對分析師意味著,儘管核心是 ML,邊界仍由人工定義,可能引入偏見。

▋沒說的第3件事:大模型真的沒有「即時」For You為你推薦

這是最關鍵,也是最少人點破的技術硬傷。有些討論聲稱演算法使用擁有 314 億參數的 Grok-1 模型,甚至有人說可以在極短時間內為每位用戶從成千上萬篇貼文中篩選並排序候選文章。

懂 AI 的人看到這裡都會倒抽一口氣:如果每次你打開 X,它都完整運行 314 億參數的模型,從上億篇文章中挑選出 1500 篇給你。那物理和經濟上挑戰極大。

Grok-1 是一個巨大的生成式模型。要讓它對「一篇」貼文進行推論(Inference),就需要龐大的算力。

如果要在極短時間內對上億篇貼文逐一進行「Grok 級別」的深思熟慮,即使用的是前面說的 MoE,混合專家模式只用 1/4 的參數,還是要 78 億個參數,這會讓伺服器成本將極其高昂,且用戶體驗可能受影響。

如果每篇文章系統都預測 15+ 種互動,還沒有經過優化,延遲會飆升。

真相是什麼?真正的運作邏輯是「雙塔模型(Two-Tower Model)」與類似知識蒸餾的優化結合:

1. 離線階段:Grok(老師)預先讀過貼文,將其轉化為數學向量(Embedding),存入資料庫,可能使用高維空間(e.g., 512-1024 維)以捕捉細微語意。

2. 線上階段:當你刷新手機時,實際上是一個輕量級的小模型(學生)在運作。它不進行複雜思考,只是快速比對向量距離,使用如 FAISS 的 ANN 索引加速搜尋。

所以,並不是那個 314 億參數的巨人親自為你服務,而是它訓練出來的輕量替身在工作。官方的說法跳過關鍵的「替身」機制,讓我們誤以為每一次滑動都是頂級 AI 的即時運算。 Phoenix 是純 Grok transformer,但從錢袋 Grok-1 移植並適應的版本,強調嚴格候選隔離以確保並行性。

▋結論

馬斯克的開源確實比黑箱作業的 Meta、TikTok 或 YouTube 進步了一大步,計算高品質回覆後,小創作者的機會也大幅提升。

@thebayeram 的指南建議,創作者應垂直深耕、鼓勵對話,並避免重複,以優化在 Phoenix 中的曝光。 但作為觀察者,我們必須明白:看得到程式碼,不代表看透了真相。在算力成本與物理極限前,是技術人的真實底子。

而我們吃瓜路人,就每四星期看看社群大神們又發現了什麼吧。追蹤 GitHub 變動和 X 上的 #XAlgorithm 標籤,能捕捉如 config 檔調整的細節,讓分析師持續拆解這有機演化的系統。